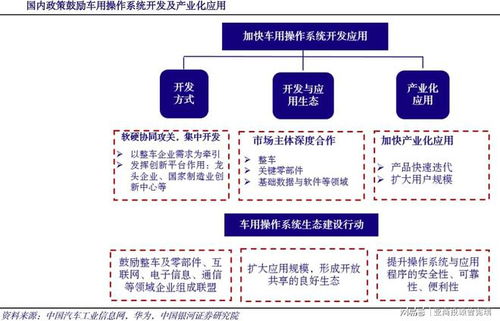

大數據架構、業務處理流程與數據處理及存儲支持服務解析

在當今數據驅動的時代,有效管理和利用海量信息已成為企業核心競爭力的關鍵。大數據技術體系為這一目標提供了系統性解決方案,其核心在于協調一致的架構設計、高效流暢的業務處理流程,以及堅實可靠的數據處理與存儲支持服務。本文將對此進行深入解析。

一、 大數據架構:構建數據處理的基石

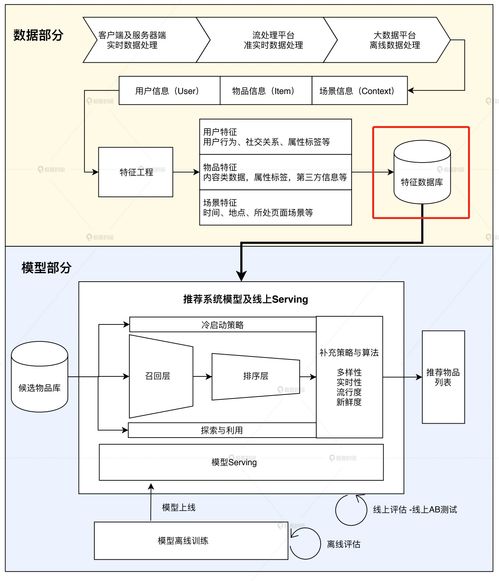

大數據架構是支撐整個數據處理體系的藍圖,它定義了數據從產生到產生價值的全鏈路中,各個組件的角色、功能及相互關系。現代主流的大數據架構通常采用分層設計思想,以確保系統的可擴展性、靈活性和可維護性。

- 數據源層:這是數據的起點,來源極其廣泛,包括業務數據庫(如MySQL、Oracle)、應用程序日志、物聯網設備傳感器、社交媒體流、第三方API等。這些數據具有多樣性(結構化、半結構化、非結構化)、高速產生和大體量的特點。

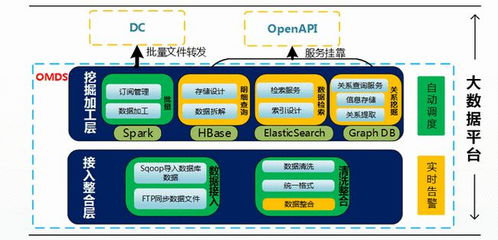

- 數據采集與 ingestion 層:負責從各種數據源實時或批量地抽取數據,并將其安全、可靠地傳輸到數據存儲或處理系統中。常用工具有 Apache Kafka(用于高吞吐量的實時數據流)、Flume、Sqoop(用于關系型數據庫與Hadoop之間的數據傳輸)等。

- 數據存儲層:這是架構的核心,負責海量數據的持久化保存。根據數據特性和訪問模式,存儲方案也呈現多樣化:

- 分布式文件系統:如 HDFS,適合存儲原始、未經處理的巨量數據。

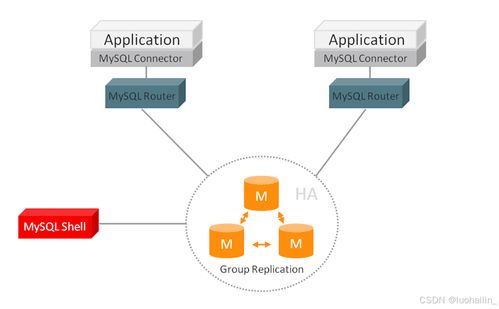

- NoSQL數據庫:如 HBase(面向列,適合快速隨機讀寫)、Cassandra(高可用、分布式)、MongoDB(文檔型,靈活 schema),用于處理半結構化和非結構化數據。

- 數據倉庫:如基于 Hive 構建的離線數倉,或 Snowflake、Amazon Redshift 等云數倉,用于存儲清洗后的結構化數據,支持復雜的OLAP分析。

- 數據湖:如基于對象存儲(如 AWS S3)構建的數據湖,允許以原始格式存儲所有類型的數據,為后續探索性分析提供最大靈活性。

- 數據處理與計算層:這是將原始數據轉化為信息和知識的核心引擎。根據時效性要求,可分為:

- 批處理:處理歷史積壓的大量數據,計算模型如 MapReduce,計算引擎如 Apache Spark(速度遠超MapReduce)、Apache Flink(也支持流處理)。

- 流處理:處理連續不斷產生的實時數據流,實現低延遲的洞察和響應,引擎如 Apache Storm、Apache Flink、Spark Streaming。

- 交互式查詢:提供對海量數據的快速即席查詢能力,工具如 Presto、Impala、Druid。

- 數據服務與應用層:將處理后的數據以可用形式提供給最終用戶或下游系統。包括:

- 數據分析與BI工具:如 Tableau、Power BI,用于可視化報表和儀表盤。

- 數據API服務:通過API接口為其他應用程序提供數據服務。

- 機器學習平臺:基于處理后的數據訓練和部署AI模型。

二、 業務處理流程:從數據到價值的旅程

一個典型的大數據業務處理流程,是數據在上述架構中流動、被加工并最終創造價值的過程。它通常遵循以下階段:

- 數據產生與接入:業務活動持續產生原始數據,通過采集層工具被實時或定時抽取、匯聚。

- 數據存儲與組織:原始數據被加載到數據湖或HDFS中保存。根據業務主題,通過ETL(提取、轉換、加載)或更現代的ELT(提取、加載、轉換)流程,將部分數據清洗、轉換后加載到數據倉庫中,形成結構良好的主題域模型(如星型模型、雪花模型)。

- 數據處理與計算:

- 對于離線分析需求,調度系統(如 Apache Airflow)會定時觸發批處理作業,進行數據清洗、聚合、關聯等復雜計算。

- 對于實時需求,流處理引擎持續消費數據流,進行過濾、窗口統計、模式識別等操作。

- 數據服務與消費:處理后的結果數據被寫入到可供高效查詢的數據庫(如HBase、ClickHouse)或直接推送到應用緩存中。數據分析師通過BI工具進行探索和可視化,業務系統通過API調用獲取實時推薦或風險評分,數據科學家在Notebook中訓練預測模型。

- 數據治理與運維:貫穿整個流程,包括數據質量管理(監控數據準確性、完整性)、元數據管理(記錄數據血緣、業務含義)、數據安全(權限控制、脫敏加密)和集群資源監控與優化。

三、 數據處理和存儲支持服務:確保體系穩健運行

為了保障大數據架構和流程的高效、穩定運行,一系列關鍵的支持服務不可或缺:

- 資源管理與調度服務:

- YARN:Hadoop 2.0 的核心組件,作為集群的資源管理和作業調度框架,允許多種計算框架(如MapReduce, Spark)共享集群資源,提高利用率。

- Kubernetes:日益成為云原生大數據平臺的事實標準,提供更精細、更靈活的容器化應用部署、伸縮和管理能力。

- 協調與配置服務:

- ZooKeeper:提供分布式協調服務,如統一配置管理、命名服務、分布式鎖和集群選舉,是 Kafka、HBase 等許多分布式系統正常運行的基礎。

- 數據集成與交換服務:

- 除了前文提到的 Kafka、Sqoop,還有如 Apache NiFi,提供可視化的數據流編排,實現強大且可靠的數據系統間路由和轉換。

- CDC工具:如 Debezium,用于捕獲數據庫的變更日志,實現實時數據同步。

- 元數據與數據目錄服務:

- Apache Atlas:為 Hadoop 生態系統提供元數據治理和服務,實現數據資產編目、分類、血緣追溯和影響分析。

- 集群監控與運維服務:

- Ambari:提供 Hadoop 集群的供應、管理和監控的Web界面。

- Prometheus + Grafana:現代云原生環境中流行的監控指標收集與可視化組合。

- 安全與權限服務:

- Kerberos:提供強身份認證。

- Apache Ranger 或 Sentry:提供集中的數據安全策略管理,實現細粒度的訪問控制(如表、列級權限)。

###

大數據架構、業務處理流程與數據處理及存儲支持服務共同構成了一個有機整體。穩健的架構設計是藍圖,清晰高效的流程是價值實現路徑,而全方位的支持服務則是確保整個系統能夠持續、可靠、安全運行的保障。隨著云原生、實時智能等趨勢的發展,這三者也在不斷演進和融合,為企業從數據中挖掘無限潛能提供著日益強大的動力。

如若轉載,請注明出處:http://www.szguangzhuo.cn/product/47.html

更新時間:2026-01-19 21:27:48